Crédito: Cortesía de los investigadores

Un nuevo enfoque de “sentido común” para la visión por computadora permite que la inteligencia artificial interprete escenas con mayor precisión que otros sistemas.

Los sistemas de visión por computadora a veces hacen inferencias sobre una escena que van en contra del sentido común. Por ejemplo, si un robot estuviera procesando una escena de una mesa para cenar, podría ignorar por completo un plato que es visible para cualquier observador humano, estimar que ese plato está flotando sobre la mesa o percibir erróneamente que un tenedor está penetrando el plato en lugar de estar apoyándose en él.

Mueva ese sistema de visión por computadora a un automóvil autónomo y las apuestas se vuelven mucho más altas; por ejemplo, tales sistemas no han podido detectar vehículos de emergencia y peatones que cruzan la calle.

Para superar estos errores, los investigadores del MIT han desarrollado un marco que ayuda a las máquinas a ver el mundo más como los humanos. Su nuevo sistema de inteligencia artificial para analizar escenas aprende a percibir objetos del mundo real a partir de unas pocas imágenes y percibe escenas en términos de estos objetos aprendidos.

Los investigadores construyeron el marco utilizando programación probabilística, un enfoque de inteligencia artificial que permite al sistema cotejar los objetos detectados con los datos de entrada, para ver si las imágenes grabadas desde una cámara son una coincidencia probable con alguna escena candidata. La inferencia probabilística permite al sistema inferir si los desajustes se deben probablemente al ruido o a errores, en la interpretación de la escena que deben corregirse mediante un procesamiento adicional.

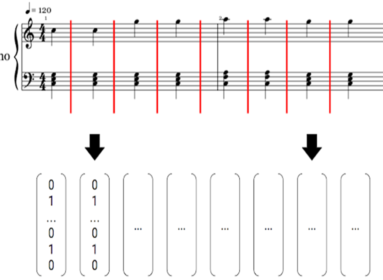

La imagen presentada muestra cómo 3DP3 (fila inferior) infiere estimaciones de pose de objetos más precisos a partir de imágenes de entrada (fila superior) que los sistemas de aprendizaje profundo (fila central).

Esta protección de sentido común permite que el sistema detecte y corrija muchos errores que afectan a los enfoques de «aprendizaje profundo» que también se han utilizado para la visión por computadora. La programación probabilística también permite inferir relaciones de contacto probables entre objetos en la escena y usar el razonamiento de sentido común sobre estos contactos para inferir posiciones más precisas para los objetos.

“Si no conoce las relaciones de contacto, entonces podría decir que un objeto está flotando sobre la mesa, esa sería una explicación válida. Como seres humanos, es obvio para nosotros que esto es físicamente poco realista y que el objeto que descansa sobre la mesa es una pose más probable del objeto. Debido a que nuestro sistema de razonamiento es consciente de este tipo de conocimiento, puede inferir poses más precisas. Esa es una idea clave de este trabajo”, dice el autor principal Nishad Gothoskar, estudiante de doctorado en ingeniería eléctrica e informática (EECS) del Proyecto de Computación Probabilística.

Además de mejorar la seguridad de los automóviles autónomos, este trabajo podría mejorar el rendimiento de los sistemas de percepción por computadora que deben interpretar arreglos complicados de objetos, como un robot encargado de limpiar una cocina desordenada.

Para desarrollar el sistema, llamado «Percepción de escena 3D a través de programación probabilística (3DP3)», los investigadores se basaron en un concepto de los primeros días de la investigación de la IA, que es que la visión por computadora puede considerarse como el «inverso» de los gráficos por computadora.

La infografía se enfoca en generar imágenes basadas en la representación de una escena. La visión por computadora puede verse como lo contrario de este proceso. Gothoskar y sus colaboradores hicieron que esta técnica fuera más fácil de aprender y escalable incorporándola en un marco construido usando programación probabilística.

“La programación probabilística nos permite escribir nuestro conocimiento sobre algunos aspectos del mundo de una manera que una computadora puede interpretar, pero al mismo tiempo, nos permite expresar lo que no sabemos, la incertidumbre. Por lo tanto, el sistema puede aprender automáticamente de los datos y detectar automáticamente cuando las reglas no se cumplen”, explica Cusumano-Towner.

Imagen: iotforall.com

En este caso, el modelo se codifica con conocimientos previos sobre escenas 3D. Por ejemplo, 3DP3 «sabe» que las escenas están compuestas por diferentes objetos y que estos objetos a menudo se colocan uno encima del otro, pero no siempre tienen relaciones tan simples. Esto permite al modelo razonar sobre una escena con más sentido común.

Para analizar una imagen de una escena, 3DP3 primero aprende sobre los objetos en esa escena. Después de mostrar solo cinco imágenes de un objeto, cada una tomada desde un ángulo diferente, 3DP3 aprende la forma del objeto y estima el volumen que ocuparía en el espacio.

“Si les muestro un objeto desde cinco perspectivas diferentes, pueden construir una representación bastante buena de ese objeto. Entendería su color, su forma y sería capaz de reconocer ese objeto en muchas escenas diferentes”, dice Gothoskar.

Mansinghka agrega: “Se trata de muchos menos datos que los enfoques de aprendizaje profundo. Por ejemplo, el sistema de detección de objetos neuronales ‘Dense fusión’ requiere miles de ejemplos de entrenamiento para cada tipo de objeto. Por el contrario, 3DP3 solo requiere unas pocas imágenes por objeto y reporta incertidumbre sobre las partes de la forma de cada objeto que no conoce”.

El sistema 3DP3 genera un gráfico para representar la escena, donde cada objeto es un nodo y las líneas que conectan los nodos indican qué objetos están en contacto entre sí. Esto permite que 3DP3 produzca una estimación más precisa de cómo se organizan los objetos (los enfoques de aprendizaje profundo se basan en imágenes de profundidad para estimar las poses de los objetos, pero estos métodos no producen una estructura gráfica de las relaciones de contacto, por lo que sus estimaciones son menos precisas).

Los investigadores compararon 3DP3 con varios sistemas de aprendizaje profundo, todos con la tarea de estimar las poses de los objetos 3D en una escena.

En casi todos los casos, 3DP3 generó poses más precisas que otros modelos y funcionó mucho mejor cuando algunos objetos obstruían parcialmente a otros. Y 3DP3 solo necesitaba ver cinco imágenes de cada objeto, mientras que cada uno de los modelos de referencia que superó necesitaba miles de imágenes para el entrenamiento.

Cuando se usó junto con otro modelo, 3DP3 pudo mejorar su precisión. Por ejemplo, un modelo de aprendizaje profundo podría predecir que un plato flota ligeramente por encima de una mesa, pero como 3DP3 tiene conocimiento de las relaciones de contacto y puede ver que esta es una configuración poco probable, puede hacer una corrección alineando el plato con la mesa.

“Me sorprendió ver cuán grandes pueden ser a veces los errores del aprendizaje profundo, al producir representaciones de escenas en las que los objetos realmente no coincidían con lo que la gente percibiría. También encontré sorprendente que solo un poco de inferencia basada en modelos en nuestro programa probabilístico causal fuera suficiente para detectar y corregir estos errores. Por supuesto, todavía hay un largo camino por recorrer para hacerlo lo suficientemente rápido y robusto para desafiar los sistemas de visión en tiempo real, pero por primera vez, estamos viendo que la programación probabilística y los modelos causales estructurados mejoran la solidez sobre el aprendizaje profundo en la visión 3D dura de puntos de referencia”, dice Mansinghka.

En el futuro, a los investigadores les gustaría impulsar el sistema más allá para que pueda aprender sobre un objeto a partir de una sola imagen, o un solo cuadro en una película, y luego poder detectar ese objeto de manera robusta en diferentes escenas. También les gustaría explorar el uso de 3DP3 para recopilar datos de entrenamiento para una red neuronal. A menudo, es difícil para los humanos etiquetar imágenes manualmente con geometría 3D, por lo que 3DP3 podría usarse para generar etiquetas de imagen más complejas.

El sistema 3DP3 “combina el modelado de gráficos de baja fidelidad con el razonamiento de sentido común para corregir errores de interpretación de escenas grandes cometidos por redes neuronales de aprendizaje profundo. Este tipo de enfoque podría tener una amplia aplicabilidad, ya que aborda importantes modos de falla del aprendizaje profundo.

Fuente: Scitechdaily.com

Comments are closed.